Klimahysteriet begrunnes ikke sjelden med en slags plikt til å «stole på vitenskapen», men er det egentlig vitenskap som ligger til grunn? Fysikeren Steven Koonin går langt i å avvise det.

Problemet er at her ligger djevelen virkelig i detaljene.

Prognosene for temperaturstigning som har skremt mange til å tro at verden blir et uutholdelig sted hvis menneskeheten fortsetter å slippe ut CO2, bygger på datamaskinberegninger som bare et knøttlite antall mennesker i verden har full innsikt i, nærmere bestemt noen titalls fagmiljøer verden rundt som ikke er noen slags ufeilbarlige vitenskapelige titaner.

Men mange flere som har dyp innsikt i skjæringspunktet mellom fysikk, matematisk modellering og datamaskinberegninger, ser klart at de katastrofale prognosene har et syltynt faglig grunnlag. Og den som mer enn noen annen har anstrengt seg for å forklare det til et bredere publikum, er nettopp Steven Koonin, selv en pioner innen datamaskinassistert beregningsorientert fysikk.

Hoover Institution, en konservativ tenketank ved Stanford-universitetet, spilte i august inn en video der den amerikanske fysikeren forsøker å vise publikum hvordan klimamodeller lages – en innsikt som er egnet til å svekke nattesøvnen like mye som kunnskaper om pølseproduksjon.

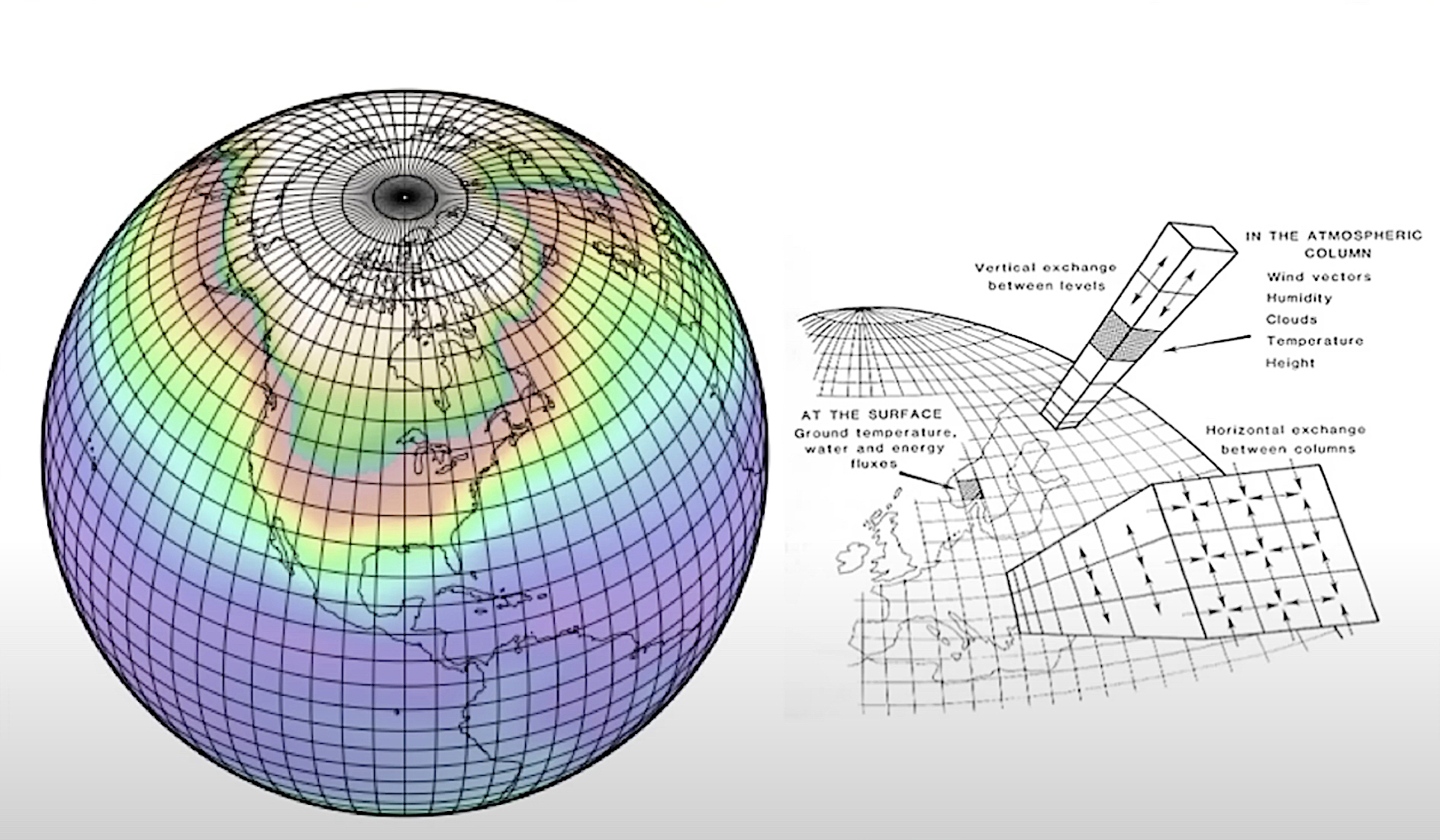

Klimamodellering begynner alltid med å lage en modell av Jordens atmosfære bestående av et tredimensjonalt gitter, der avstanden mellom gitterpunktene typisk er 100 kilometer over landjorden og 10 kilometer over havet.

Problemet er at når man formulerer de fysiske lovene matematisk og anvender dem på et slikt gitter, så er det flere klimarelevante fenomener, for eksempel skyer, som ikke fanges opp godt nok når tilstanden antas å være homogen innenfor hver enkelt boks definert av åtte gitterpunkter.

Og det er nettopp idet klimaforskere forsøker å bøte på den mangelen at de tar steget fra vitenskap og over i modellbygging. Det er en aktivitet som krever skjønn, og den egenskapen er langt fra ufeilbarlig.

Når kan en modell sies å være god nok til å fortjene betegnelsen vitenskap? For klimamodellenes vedkommende er det når de har demonstrert evne til å forutse klimaet. Men det har de ikke gjort, og hva verre er: Modellene er innbyrdes motstridende, slik at man gjerne benytter et gjennomsnitt av modellberegninger som prognose.

Men det Koonin også går langt i å antyde, er at modellbyggerne jukser idet de estimerer størrelsen på de mange fysiske parametrene i modellene de har bygd. For å få modellberegningene til å stemme overens med det historiske klimaet, skrur de på disse parametrenes tallstørrelser for å gjenskape historikken, uten at det nødvendigvis finnes noen fysisk berettigelse for det foretrukne tallet.

Og da er det at matematikere og statistikere verdt sitt salt bør reagere: Er det sånn at en veldig kompleks modell med mange parametre som gjenskaper fortiden, er egnet til å forutse fremtiden?

Mange i bransjen vil da svare «nei» fordi de er oppmerksome på fenomenet som på fagspråket kalles overfitting, eller «overtilpasning».

Dette er ikke enkelt å forklare for allmennheten, men det er interessant at Hoover Institution, hvor man åpenbart trekker klimamodellenes pålitelighet i sterk tvil, lar Koonin gi publikum et glimt av det som skjer i disse fagmiljøenes kulisser.

Tenketanken har siden spilt inn et lengre intervju med den kjente fysikeren.

Man skal ikke dykke så langt ned i denne materien før man innser at det å forsøke å revolusjonere energisystemene, økonomien og hele samfunnet på bakgrunn av en avansert lek med tall som ikke er ordentlig vitenskap, er et komplett galehus.

Men nå er det engang et slikt vi lever i. Og jo før vingene smelter på både de kvasivitenskapelige og de politiske Ikaros’ene, jo bedre.

Kjøp «Usikker vitenskap» av Steven E. Koonin som papirbok og som e-bok.